再获国际权威认可!连信数字获ACM MM 2025微表情识别大赛总冠军

近日,在爱尔兰都柏林举行的ACM MM 2025国际微表情识别大赛中,连信数字团队凭借其前沿研究成果《基于多模态大语言模型的微表情视觉问答方法》获得总冠军。该团队由连信数字副总裁王雨晶与洞见研究院副院长黄杏代表,赴现场接受了这一国际奖项。

微表情(Micro-Expressions, MEs)是人们在试图隐藏真实情感时自发产生的一种短暂面部表情,持续时间通常仅为1/25~1/3s。由于其持续时间极短、表现幅度小且常局限于局部肌肉变化,微表情在人机交互、心理分析、情绪识别等领域具有重要的研究与应用价值,通过精准捕捉和解析个体的微表情,可有效揭示潜在的情绪波动与心理状态。

随着多模态大语言模型(MLLM)与大视觉语言模型(LVLM)的跨越式发展,微表情识别技术正加速从实验室研究走向实际应用,成为“人本世界模型”的加速突破口。我们此次推出的创新成果,以对人的识别、分析与预测为核心切入点,致力于解决真实世界中的复杂问题,已在多个领域展现出广泛的应用价值:在心理健康领域,助力潜在风险的早期筛查;在社会治理领域,实现对关键人物的风险评估与行为预判;在安全领域,支持敏感对象的易感性分析;在企业招聘中,提升人岗匹配的精准度;在金融风控环节,增强欺诈识别能力;在日常生活中,更能洞察个体真实诉求,促进有效沟通。连信数字持续推动“机器读懂人心”从理念走向实践,让这一技术真正赋能千行百业,服务于社会治理优化、企业效能提升与民生需求满足。

公开信息显示,连信数字是一家专注于心理大数据智能应用领域的科技创新企业,被业内称为心理行业的“Palantir”,同时也是AGI时代“人本模型”的开创者。该公司融合心理学、社会学、人类学、教育学、管理学、经济学、犯罪学等多学科理论与高新技术,打造了全球首个理解人类行为与心理的“洞见人和”人本世界模型(国家双备案)。该模型能够通过少量线索对人进行全面分析并落地应用,实现AI对于世界和人的全面感知理解(“世界模型”),促进人与AI的无缝连接,形成对社会复杂系统本质规律的认知、推理和预测,从而打造理解人类内心及其与世界互动的智能基础设施。

近年来,连信数字逐步构建起极具泛化能力的人工智能时代标杆性基础设施,并衍生出多元商业模式与产品矩阵,涵盖多业务智能体、数据智能体、云能力开放平台三大体系。产品自上而下贯穿国家安全、社会维稳、企业发展,民生健康,具有广阔的延展空间。目前,该公司已在社会维稳(公安、司法等)、B端教育等领域取得商业验证成功,累计服务超400家客户。业务覆盖全国二十多个省/直辖市/自治区,为数千万用户提供各领域心理应用服务。

此次连信数字团队在国际赛事中问鼎,不仅表明其在微表情识别技术上已处于全球领先水平,也标志着该公司在“人本世界模型”科研领域取得重要进展。随着人工智能在心理与行为理解方面的不断突破,相关技术有望在更多实际场景中落地,推动人机协同与智能化社会治理的深入发展。

论文介绍:

微表情是人类在试图掩饰真实情绪时,所产生的短暂而非自愿的面部表情 。这些表情持续时间极短,通常只有 1/25 到 1/5 秒,且涉及微妙的局部肌肉运动,因此很难被察觉 。由于其非自愿性,微表情被认为是情绪识别、心理评估和测谎的重要线索,传统的微表情识别(MER)方法依赖手工特征和浅层分类器,难以捕捉面部运动中细微的时空动态 。尽管深度学习方法有所改进,但它们依然面临数据有限、泛化能力弱和缺乏可解释性的挑战 。此外,现有的大多数 MER 模型只能进行封闭集标签预测,无法支持语义解释或基于语言的交互 。

本论文首次提出了一个为微表情理解而全面微调的大型视觉-语言模型(Emotion-Qwen-VL),突破传统方法在细粒度面部动态捕捉与语义对齐中的瓶颈。研发团队构建了融合情感类别与动作单元(AU)标注的大规模指令问答数据集,数据集涵盖了三种问答类型:情感分类、AU 检测和因果推理,通过语言驱动实现高精度视觉—语义映射,显著提升模型的可解释性与推理连贯性。

实验结果分析中,研究人员在 MEGC 2025 测试集上对 Emotion-Qwen-VL 进行了评估,实验结果证明,该模型在多个维度上都显著优于强基线模型(如 Qwen2.5-VL 和 QVQ)。这包括粗粒度宏表情分类、细粒度微表情分类以及语言生成质量(BLEU/ROUGE)。

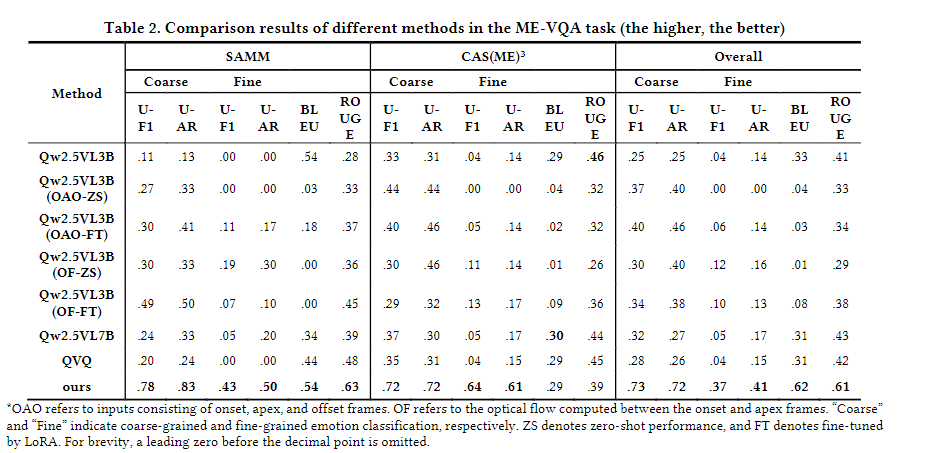

不同方法在 ME-VQA 任务上的比较结果该表格比较了 Emotion-Qwen-VL 模型与多个基线模型在 ME-VQA 任务上的表现 。它使用了无权重 F1 分数(UF1)、无权重平均召回率(UAR)、BLEU 和 ROUGE-1 等指标,并分别在 SAMM、CAS(ME)3 和总体测试集上展示了结果 。该表格清楚地显示,我们的模型在大部分指标上都显著优于所有基线模型 。

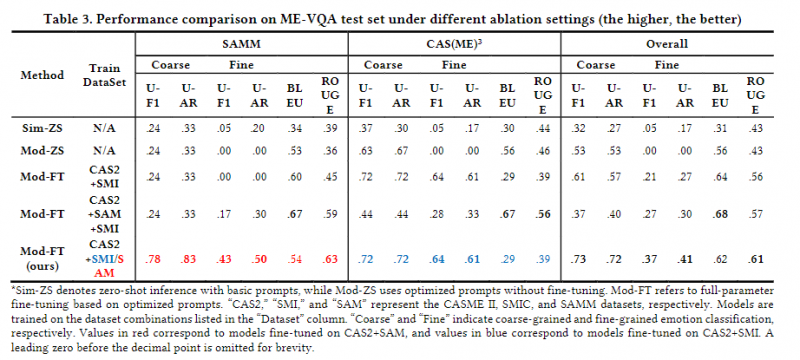

不同消融设置下 ME-VQA 测试集上的性能比较该表格展示了不同消融实验设置下的模型性能比较 。它比较了使用不同提示词("Sim" 指代简单提示,"Mod" 指代结构化提示)以及不同微调策略和训练数据集组合对模型性能的影响 。结果表明,Mod-FT(即全参数微调)显著优于零样本学习(ZS)方法 ,且训练数据的组成对性能有决定性影响 。

同时,研究人员还进行了消融研究,以探究提示词设计、微调策略和训练数据构成对模型性能的影响。研究结果表明:

● 精心设计的提示结构可以显著增强模型的零样本泛化能力,即使没有进行参数更新

● 在改进的提示设计基础上进行全参数微调,可以进一步提升模型在所有指标上的性能,对于捕捉微表情的细微时序动态至关重要 。

● 训练数据的构成对性能起着决定性作用 。识别任务在训练和测试分布对齐时表现最佳 。

随着多模态大语言模型(MLLM)和大视觉语言模型(LVLM)的跨越式发展,微表情识别技术正加速走向实用化、智能化。这一技术突破为微表情分析提供了可解释、语言交互式的研究新路径,极大推动了微表情识别技术在真实场景中的落地应用。在心理危机预警、智能审讯辅助、校园心理监测、司法评估、心理健康服务等领域具有广阔应用前景。

责任编辑:知行顾言

随便看看:

网友评论:

推荐使用友言、多说、畅言(需备案后使用)等社会化评论插件